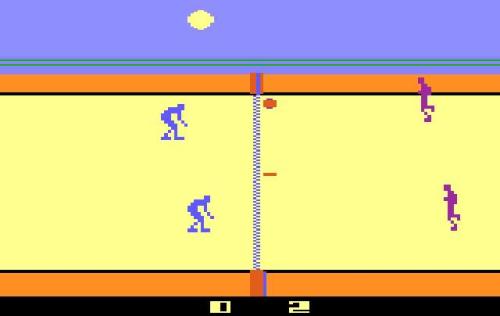

2015年,谷歌的DeepMind AI的任务是学习玩Atari视频游戏。它也非常成功,在视频弹球方面与人类玩家一样出色。但由于游戏的复杂性,除了简单的街机游戏之外,它开始挣扎,众所周知甚至未能收集传奇的20世纪80年代冒险游戏Montezuma's Revenge中的第一把钥匙。

然而,一种新方法导致了一种AI算法,该算法从错误中学习,并确定中间步骤的速度提高了10倍,在Google失败并成功自主玩Montezuma's Revenge之后取得了成功。

这项工作由Fabio Zambetta及其团队在澳大利亚墨尔本的RMIT大学进行。Zambetta 于2月1日在夏威夷举行的第33届AAAI人工智能会议上介绍了这一发现。

设计可以克服计划问题的人工智能,例如奖励不是很明显,是推动该领域最重要的挑战之一。

人工智能在冒险游戏中挣扎的原因是,在发现一些奖励之前,它认为没有动力选择一种行动方式而不是其他任何一种方式,例如实现爬梯或跳过坑到达更大目标的子目标水平。

他们感到困惑并无法确定前进的道路,而只是随意开始行动。

对于某些游戏,例如弹球,奖励在附近,算法获得所需的外部输入。

然而,在一个冒险游戏中,奖励更加分散,鸡和蛋的情况发展。该程序发现自己无法改善其游戏玩法,直到获得一些奖励,但在改进其游戏玩法之前不会找到奖励。

为了解决这个问题,Zambetta从其他电脑游戏中汲取灵感,如超级马里奥和Pacman,并引入了颗粒奖励,提供了小的中间奖励,并鼓励它探索和完成子目标。

“真正聪明的人工智能需要能够学会在模糊的环境中自主完成任务,”他说。

“我们已经证明,正确的算法可以使用更智能的方法改善结果,而不是纯粹粗暴地在非常强大的计算机上端到端地解决问题。”

这种方法意味着算法将更自然地行动,并且完成子目标的速度比其他AI方法快10倍。

“不仅我们的算法在玩Montezuma's Revenge时自动识别相关任务的速度比Google DeepMind快10倍,他们还表现出相对类似人类的行为,”Zambetta声称。

“例如,在你可以进入游戏的第二个屏幕之前,你需要确定一些子任务,例如爬梯子,跳过一个敌人,然后最终拿起钥匙,大致按照这个顺序。

“这最终会在很长一段时间后随机发生,但在我们的测试中如此自然地发生了某种意图。

“这使我们成为第一个完全自主的面向目标的代理商,与这些游戏中最先进的代理商真正竞争。”

虽然听起来微不足道,但这项工作在游戏之外可能很重要。根据Zambetta的说法,激励子目标可能有利于控制自动驾驶汽车的算法以及需要机器人助手在现实世界中实现目标的其他情况。